Der Normalfall in der Technischen Kommunikation ist eine Kombination von Text und Bild. Beide können sich inhaltlich perfekt ergänzen und werden dann zum didaktischen Traumpaar [1].

Geteilte Aufmerksamkeit

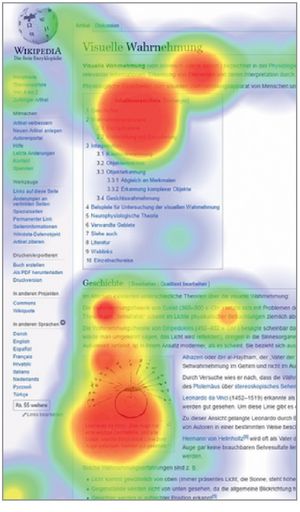

Während es bei Zeitungen oder Zeitschriften nicht so wichtig ist, dass Text und Bild zusammen ausgewertet werden, ist das in Technischen Dokumentationen anders: Hier muss zum Verständnis oft ein Bezug zwischen Text und Bild hergestellt werden: Ein Bild zeigt Gerätekomponenten, der Text enthält ihre Benennungen; der Text spricht eine Warnung aus, das Bild zeigt die Gefahr. Text und Bild werden beide mit den Augen aufgenommen, der Blick muss hin und herspringen und landet auch nicht immer auf der richtigen Position im Text oder Bild. Aber nur was fixiert wird, das wird auch kognitiv verarbeitet. Da die Aufmerksamkeit zwischen Text und Bild aufgeteilt werden muss, sprechen Psychologen vom Splitattention-Effekt (Abb. 01).

Abb. 01 Eine Wikipediaseite dargestellt als so genannte Heatmap: Die Areale mit den meisten Fixationen sind rot gekennzeichnet. Die Einleitung, der Anfang des Inhaltsverzeichnisses und das Bild unten ziehen die meiste Aufmerksamkeit auf sich. Quelle Wikimedia Commons

Bei Print-Dokumentation ist die Steuerung der Augenbewegungen vom Text in das Bild und umgekehrt schwierig. Oft wird versucht, die Betrachtenden über ausdrückliche Hinweise, Sehanleitungen oder unbestimmte Ausdrücke ins Bild zu locken: „Die Lenkschnecke hat eine spezielle Form, um die Drehung des Lenkrades in eine Schwenkbewegung der Räder zu übertragen.“ Welche spezielle Form? Jetzt wandern die Augen ins Bild.

Visual World Paradigma

In einer Pionierarbeit konnte Roger Cooper bereits 1974 den Einfluss gesprochener Sprache auf die Bildwahrnehmung feststellen [2]: Er setzte seinen Versuchspersonen ein Gerät auf den Kopf, das die Blickbewegungen erfasste, damals eine sehr umständliche Prozedur. Dann zeigte er ihnen eine Szene, zu der ein Text gesprochen wurde, der inhaltlich auf bestimmte Bildkomponenten Bezug nahm. Die Ergebnisse: Die Fixationen wurden zu 55 Prozent über gerade gehörte Wörter gesteuert, zu 40 Prozent erfolgten sie 200 msec nach den gehörten Wörtern. Wird im Text ein bestimmtes Wort ausgesprochen, zum Beispiel „Vogel“, so schaut der Hörende in einem Bild auf den Vogel. Also eine fast vollständige Steuerung der Bildauswertung über die Sprache! Erst 20 Jahre später wurde die Versuchsanordnung von dem Psycholinguisten Michael Tanenhaus wieder aufgegriffen und seitdem werden unter dem Label „Visual Word Paradigma“ unzählige Experimente durchgeführt, bei denen jedoch vor allem die Sprachverarbeitung durch die visuelle Umgebung im Zentrum steht [3].

Mündliche Steuerung

Bisher hat man mit schlichten visuellen Vorgaben experimentiert. Aber vermutlich funktioniert die sprachliche Steuerung auch bei komplexen Bildern und da ist sie auch besonders wichtig. Die Befunde sind nicht nur für Kunstführer, Filmgestalter oder Werbefachleute interessant, sondern auch für die mobile Dokumentation über Tablets oder Smartphones. Dort sind gesprochene Begleitkommentare ein perfektes Mittel, um eine integrative Auswertung von Text und Bild anzuregen. Ein kleines Display lässt zudem den Augen wenig Auslauf, so dass der Benutzer bzw. die Benutzerin wenig abgelenkt werden.

Die Blickbewegungsforschung ist ein schönes Beispiel, dass wissenschaftliche Grundlagenforschung praktische Konsequenzen haben kann.

Literatur zum Beitrag

[1] Ballstaedt, Steffen-Peter (2009): Text und Bild: ein didaktisches Traumpaar. In: Bildwelten des Wissens. Kunsthistorisches Jahrbuch für Bildkritik. Band 7.1, S. 45–55.

[2] Cooper, Roger M. (1974): The control of eye fixation by the meaning of spoken language: A new methodology for the real-time investigation of speech perception, memory, and language processing. Cognitive Psychology, 6, S. 84–107.

[3] Huettig, Falk; Rommers, Joost; Meyer, Antje S. (2011): Using the visual world paradigm to study language processing: A review and critical evaluation. Acta Psychologica, 137, S. 151–171.