„Für eine Maschine zu schreiben, ist wie der Versuch, einer Katze das Bellen beizubringen.“ Dieser Satz wurde vom GPT-3-Modell von OpenAI generiert und fasst sehr gut das Dilemma zusammen, in dem wir uns befinden. Auch wenn es im Internet sicherlich Videos bellender Katzen gibt. Der Kern der Herausforderung liegt für uns darin, dass moderne KI-Systeme keine Regeln verwenden. Sie generieren Sprache mit Hilfe von Wahrscheinlichkeitsberechnungen. Ein System ohne Regeln macht es uns schwer, Schreibregeln für maschinengerechtes Schreiben zu definieren.

Möglichkeiten und Chancen

Künstliche Intelligenz kann vielerlei bedeuten. Für unsere Zwecke betrachten wir künstliche Intelligenz im Kontext der natürlichen Sprache. Für uns ist KI die Fähigkeit von Computersystemen, Sprache zu verstehen und entsprechend zu handeln.

Dieser Artikel ist ein Beispiel für die aktuellen Möglichkeiten und Chancen in diesem Bereich. Etwa 15 Prozent seines Inhalts wurden aktiv mit Unterstützung von künstlicher Intelligenz verfasst und etwa 20 Prozent des Inhalts wurden von künstlicher Intelligenz beeinflusst, insbesondere im Hinblick auf die KI-gestützte Suche nach Informationen über die Themen, um die es hier geht.

Wie gut ist das Verstehen?

Im Übersetzungsbereich leitete 2016 Google Translate (GNMT) ein neues Zeitalter ein. Die damalige neuronale maschinelle Übersetzung (NMÜ/NMT) basiert auf neuronalen Netzwerken und Big Data. Die Übersetzung war bereits gut. In den letzten sechs Jahren wurden weitere enorme Fortschritte gemacht. Fehler kommen zwar noch vor, aber die Qualität von MÜ-Systemen ist innerhalb weniger Jahre rasant gestiegen, etwa im Hinblick auf die Erkennung kontextabhängiger Bedeutungen.

Derzeit werden bereits mehrere Aufgaben relativ erfolgreich von verschiedenen künstlichen Sprachmodellen unterstützt:

- Neuronale maschinelle Übersetzung

- Verfassen von Texten (zum Beispiel Blogartikel, Newsartikel oder Beiträge in sozialen Medien)

- Zusammenfassung von Texten

- Klassifizierung von Texten/ Dokumenten

- Beantwortung von Fragen

- Extraktion von Informationen aus Texten (Knowledge Mining)

- Stimmungsanalyse

- Umwandlung von Sprache in Text

- Umwandlung von Text in Sprache

Zwei typische Fälle

In den Bereichen Technische Kommunikation und Übersetzungen gibt es derzeit zwei Anwendungsfälle. Diese Fälle eignen sich, um Methoden für maschinengerechtes Schreiben zu entwickeln:

- Schreiben für die maschinelle Übersetzung – inwiefern können Autoren ihre Texte so optimieren, dass neuronale maschinelle Übersetzungssysteme bessere Übersetzungen produzieren?

- Verfassen von Texten, die von Maschinen verstanden werden – dies ist zum Beispiel bei Texten der Fall, die Maschinen für uns Menschen klassifizieren, zusammenfassen oder aus denen sie Informationen extrahieren.

Für die maschinelle Übersetzung

Bei der Übersetzung von einer Sprache in eine andere machen neuronale maschinelle Übersetzungssysteme aufgrund der Komplexität der Sprachen oft Fehler. Diese Fehler können auf mangelnde Präzision der Engines, Mehrdeutigkeiten im Ausgangstext, Verwendung von Fachjargon, Wortwahl oder Syntax zurückzuführen sein. Die naheliegende Frage lautet: Was kann ich als Autorin oder Autor tun, um möglichst viele dieser Verständnisfehler zu vermeiden?

Bevor es an die Antwort geht, müssen wir zuerst die Ursachen für die Fehler durch neuronale maschinelle Übersetzung verstehen. Ist dies einmal geschehen und sind die Fehler reproduzierbar, lassen sich Aktionen entwickeln, um Maschinenfehler auf ein Minimum zu reduzieren.

NMÜ verstehen

Unsere heutigen maschinellen Übersetzungssysteme basieren auf neuronalen Netzen (NN). Sie haben die statistischen maschinellen Übersetzungsmodelle (SMT) weitgehend abgelöst. Die meisten Übersetzungs-Engines benutzen einen Encoder für das Erlernen der Ausgangssprache und einen Decoder für das Generieren einer Übersetzung.

Das Grundprinzip neuronaler Netze mit mehreren verborgenen Neuronenschichten besteht darin, aus einem Input (einer Menge von Sätzen) zu lernen, welche Eigenschaften die Satzelemente haben und wie stark sie miteinander verbunden sind. Ein Netz besteht aus Schichten, die wiederum aus Neuronen bestehen. Google Translate (GNMT, Stand 2016) verfügt beispielsweise über acht Encoder-Schichten und acht Decoder-Schichten. Jedes Neuron in einer Schicht führt eine Berechnung durch. Jede Schicht des neuronalen Netzes ist für einen bestimmten Aspekt dieser Berechnungsaufgabe zuständig. Das Trainingsmodell generiert dann ein Wahrscheinlichkeitsmodell, aus dem ein NMÜ-System die wahrscheinlichste Übersetzung eines Wortes oder einer Wortgruppe ableitet. Linguistische Modelle, die auf diese Weise trainiert werden, haben zwei Eigenschaften, die für unseren Zweck (maschinengerecht schreiben) entscheidend sind: Es sind prädiktive und generative Modelle.

Für das Training von Übersetzungsmodellen können drei verschiedene Arten von neuronalen Netzen verwendet werden: Recurrent Neural Network (RNN), Convolutional Neural Network (CNN) und schließlich Transformers. Letztere entsprechen dem aktuellen Stand der Technik. Diese unterschiedlichen Netzwerkarchitekturen haben einen Einfluss auf die Art und Häufigkeit bestimmter maschineller Übersetzungsfehler. Zusätzlich spielen drei weitere Aspekte bei der Qualität der Übersetzungen eine Rolle:

- Die gewählten Trainingsdaten für das MÜ-Modell, zu denen auch die Sprachkombination gehört.

- Die Konfiguration des Trainings: Parameter wie die Länge der Wortvektoren oder die Lernrate

- Die Themen und Texte bzw. Textsorten, die mit der trainierten Übersetzungs-Engine übersetzt werden, sowie deren Eigenschaften (zum Beispiel Satzlänge, Syntax, Fachwortdichte).

Nomenklatur der NMÜ-Fehler

Inzwischen existieren viele Beschreibungen, Artikel und Präsentationen über Fehler maschineller Übersetzungssysteme. Tabelle 01 zeigt eine Übersicht der Fehler, die am häufigsten genannt wurden.

Nicht alle maschinellen Übersetzungsfehler haben gravierende Folgen. Manche betreffen lediglich Zeichensetzung oder Rechtschreibung. Ebenso ist es in manchen Fällen nicht tragisch, wenn ein Fachausdruck nicht einheitlich übersetzt wurde. Mehrere dieser Fehler lassen sich durch einfache Maßnahmen beheben. Dazu zählen die Durchführung einer Rechtschreibkontrolle vor Freigabe eines Dokuments oder die korrekte Anwendung stilistischer oder terminologischer Regeln wie die einheitliche Schreibweise von Fachbegriffen und Namen oder die richtige Verwendung von Kommaregeln.

Auch können einige dieser Fehler durch eine geeignete Konfiguration der verwendeten Übersetzungs-Engines vermieden werden, etwa durch Vorgabe eines bestimmten Sprachregisters (formell oder informell). Problematisch werden die Fehler, wenn es im weitesten Sinne um Verständnisfragen geht. Mit diesen Fehlertypen wollen wir uns näher beschäftigen.

Tabelle 01 mit typischen Fehlern maschineller Übersetzung (PDF).

Fehler und Halluzinationen

In maschinellen Übersetzungen können Fehler auftreten, die die Informationen des Ausgangstextes verfälschen oder sogar zu falschen Handlungen oder Schäden führen. Diese Art von Fehlern, die in der MÜ-Literatur auch als katastrophale Fehler bezeichnet werden, müssen unbedingt erkannt und vorab vermieden werden. Katastrophale Fehler treten beispielsweise bei der Übersetzung von Eigennamen, Zahlen und Maßeinheiten auf. Oder dann, wenn der Text eine Negation oder eine entgegengesetzte Bedeutung enthält. Halluzinationen kommen vor, wenn maschinelle Übersetzung Informationen generiert, die im Ausgangstext gar nicht existieren.

Katastrophale Fehler oder Halluzinationen sind oft schwer zu entdecken, weil der übersetzte Text sich sonst leicht und fließend lesen lässt. Es gibt fünf Ursachen für solche Fehler:

- fehlendes Weltwissen

- falsches Verständnis von Benennungen

- Nicht-Erkennen neuer Wörter oder Eigennamen

- Fehlen logischen Denkens, das dem Menschen eigen ist

- Mechanismus für die Erzeugung von Übersetzungen

Fehlendes Weltwissen: Die 86 Milliarden Neuronen, die ein menschliches Gehirn im Schnitt hat, haben eine enorme Menge an Wissen aufgebaut. Wir wissen, dass im Satz „Brüssel hat beschlossen, dass …“ meistens die Europäische Kommission gemeint ist, oder dass der Ausdruck „ich habe fertig“ eine Anspielung an das berühmte Zitat von Fußballtrainer Giovanni Trapattoni ist. Trotz der heutigen schieren Unmengen an Trainingsdaten fehlt den Maschinen bislang dieses Weltwissen. Sie übersetzen solche Texte wörtlich.

Falsches Verständnis von Benennungen: Es ist wichtig, nachzuvollziehen, wie eine Maschine die Bedeutung eines Wortes bestimmt. Das passiert ganz anders als bei einem Menschen. Maschinen stellen Wörter (eigentlich „Tokens“) als Vektoren dar. Diese Vektoren enthalten eine Reihe von Zahlen, zum Beispiel 512, 768 oder 2.048 Zahlen, die die Beziehung des Wortes zu anderen Wörtern und andere Informationen, etwa die Wortposition, enthalten. Da Vektoren mathematische Objekte sind, können sie multipliziert, addiert und miteinander verglichen werden. So kann ein neuronales Sprachmodell folgende Berechnung durchführen:

„Film – Schauspieler = Dokumentarfilm“

Im Gegensatz zu den Anfängen der neuronalen Übersetzungssysteme sind die Systeme heute in der Lage, zwischen zwei verschiedenen Verwendungskontexten für dasselbe Wort zu unterscheiden. Ein Beispiel ist das Wort Verteiler, das in folgenden Sätzen vorkommt und von den meisten NMÜ-Systemen unterschiedlich interpretiert wird:

- Der Verteiler befindet sich in der Nähe der Trafostation

- Die Abteilung wird in den Verteiler für freigegebene Dokumente aufgenommen.

Wenn Maschinen Wörter und Kontexte verstehen, warum passieren diese maschinellen Missverständnisse, die sogar zu einer Katastrophe führen können? Wenn wir Menschen etwas verstehen, verstehen wir es als eine Gruppe von Begriffen, die auf eine bestimmte Art und Weise miteinander verbunden sind. Die Semantik dieser Art von Verbindung von Begriffen ist wichtig. Man erkennt als Mensch nicht nur, dass Auto und Motor ein gemeinsames Thema haben, sondern auch, dass der Motor das Auto antreibt. Maschinen wurden dagegen nur auf formale Aspekte der Sprache trainiert. Sie führen lediglich Berechnungen durch und ermitteln: Wo ein Auto ist, ist auch ein Motor vorhanden – mehr nicht. Was fehlt, ist das logische Verständnis und die persönliche Erfahrung mit dem zu verstehenden Begriff.

Dass Benennungen manchmal missverstanden werden, liegt daran, dass Maschinen ausschließlich Berechnungen benutzen, um Dinge zu verstehen. Wenn zwei Wörter oder Sätze wenig miteinander zu tun haben, dann wird eine linguistische Maschine relativ zuverlässig feststellen, dass deren Vektoren sehr weit auseinander sind. So erkennt ein System, dass

- Ich fand die tekom-Tagung sehr interessant

- Ab dem 1. Januar gelten die neuen Regelungen

- nur zu 34 Prozent ähnlich sind, während

- Ich fand die tekom-Tagung sehr interessant

- Ich fand die tekom-Tage sehr interessant

- zu 95 Prozent gleich sind.

Wenn die Verwendungskontexte beinahe identisch sind, aber einzelne Wörter semantisch eine grundsätzlich entgegengesetzte Bedeutung haben, kann es zu Problemen kommen. Das ist bei einer Negation der Fall. Die Maschine würde die Sätze

- Ich fand die tekom-Tagung sehr interessant

- Ich fand die tekom-Tagung nicht interessant

zu 92 Prozent als übereinstimmend betrachten und gelegentlich sogar eine der Varianten als Übersetzung anbieten. Für uns Menschen ist der Grad der Übereinstimmung hingegen bei null.

Nicht-Erkennen neuer Wörter oder Eigennamen: Viele Themen der Technischen Kommunikation haben ganz oder zum Teil etwas mit Innovationen zu tun. In diesen Fällen ist es nicht außergewöhnlich, dass in einer Technischen Dokumentation neue unbekannte Wörter erscheinen oder dass bestehende Wörter eine neue Bedeutung erhalten. Solche Wörter können ebenfalls Eigennamen sein, die Produkte oder Prozesse benennen.

Wenn Namen von Personen, Produkten, Organisationen auch ihr Gegenstück als normale Wörter in der Alltagssprache haben, kann es passieren, dass NMÜ-Systeme sie dann wörtlich übersetzen. MÜ kann dies auch mit einem Teil des Wortes tun, da viele NMÜ-Systeme nicht nur mit Wörtern, sondern auch mit kleineren Einheiten (etwa Gruppen von vier Buchstaben) trainiert worden sind. Das zeigt dieses Beispiel mit dem erfundenen Wort Vorflaboid. MÜ übersetzt dieses nichtexistierende Wort mit pre-flaboid.

Im Hinblick auf das maschinengerechte Verfassen von Texten für die maschinelle Übersetzung ist es eine Strategie, die Eigennamen auf diese Gefahr hin zu sichten, um sie mit einem Mini-Kontext zu versehen (etwa mit der Apposition der Kurort Langweiler) oder sie in die Terminologie aufzunehmen, um eventuelle Problemfälle bei der Nachbearbeitung gezielt erkennen zu können.

Fehlen logischen Denkens, das dem Menschen eigen ist: Aussagen wie „DHL hat eingestellt, und dennoch bleibt die Zustellung seit Monaten eingestellt“ sind mehrdeutig. Die meisten Leserinnen und Leser erkennen durch Logik, wie sie zu deuten sind. MÜ verwendet hier in beiden Fällen stopped.

Der Punkt ist, dass diese Art von Schlussfolgerung einem Menschen eigen ist. Ein maschinelles Übersetzungssystem macht in dieser Situation hingegen Fehler, die schwerwiegende Folgen haben können.

Mechanismus zur Generierung der Übersetzung: Die Art und Weise, wie ein neuronales maschinelles Übersetzungssystem Übersetzungen generiert, ist der Hauptgrund dafür, dass wir das Phänomen der Halluzinationen haben – das Hinzufügen von Informationen im Satz. Das gilt ebenfalls für das Weglassen von Inhalten. Wenn also eine bestimmte Wortkombination sehr wahrscheinlich ist, wird das Sprachmodell sie eventuell auch dann produzieren, wenn sie sich im Ausgangstext nicht befindet oder wenn sie logisch keinen Sinn macht.

Dieser Mechanismus lässt sich auf DeepL beobachten. Abbildung 01 zeigt eine Auswahl alternativer Übersetzungen, die auf den von DeepL gelernten Kontexten basieren. Eine davon enthält eine Halluzination.

Abb. 01 Eine „Halluzination“ in DeepL, denn das englische Wort „considerable“ ist an dieser Stelle falsch. Quelle François Massion; DeepL

Schreiben in der Praxis

Will man maschinengerecht schreiben, gilt der erste Gedanke der kontrollierten Sprache. Bezogen auf die beschriebenen Fehlertypen lassen sich einige Grundregeln für die Technische Redaktion ermitteln, die sich an einer kontrollierten Sprache orientieren:

- Nur eine Bedeutung pro Wort zulassen.

- Terminologie und Schreibweise von Termini und Eigennamen vereinheitlichen.

- Kurze Sätze* bilden, zum Beispiel darf ein Satz nicht mehr als einen Nebensatz haben.

- Füllwörter wie nur, doch, eigentlich streichen.

- Satzzeichen in Sätzen systematisch setzen.

- Abkürzungen und neue Begriffe erläutern.

(* NMÜ-Systeme können heute viel besser mit längeren Sätzen umgehen als zu Beginn der NMÜ-Ära. Zur Wiederverwendbarkeit von Content und Übersetzung ist es jedoch immer besser, kürzere Sätze zu schreiben.)

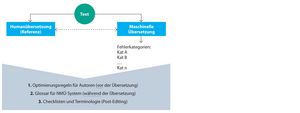

Funktionieren diese Regeln auch bei Texten bzw. bei Übersetzungsprojekten eines bestimmten Unternehmens? Da das Verhalten der Übersetzungs-Engines nicht regelbasiert und daher nicht planbar ist, führt letztlich kein Weg an einer Reihe von Tests und Optimierungsversuchen vorbei. Aus diesem „Trial-and-Error“-Vorgehen ergeben sich drei Arten von Ergebnissen:

- Schreibregeln für Autoren, um vor der Übersetzung einige der vorhersehbaren maschinellen Übersetzungsfehler in ihren Texten effektiv zu vermeiden.

- Glossare, die bei einigen MÜ-Systemen während der Übersetzung verwendet werden können, um das MÜ-Ergebnis zu beeinflussen.

- Checklisten und Terminologien, die nach der Übersetzung helfen, die spezifischen maschinellen Übersetzungsfehler für das Post-Editing zu identifizieren.

Die Ausarbeitung redaktioneller Regeln und spezifischer Terminologie kostet natürlich Zeit. Der Löwenanteil dieser Arbeit fällt vorwiegend in die Einführungsphase einer maschinellen Übersetzungslösung (Abb. 02).

Abb. 02 Entstehung von Regeln während der Einführung maschineller Übersetzung. Quelle François Massion

Für den Wissensaustausch

Die zweite Situation, in der Personen für Maschinen schreiben, betrifft den Wissensaustausch. Dieser Austausch erfolgt nur in einer Sprache. Die Maschine soll den Text eines Autors richtig verstehen, um eine Aktion auf der Grundlage des Inhalts durchzuführen, zum Beispiel den Text zusammenfassen oder Metadaten aus einem Dokument extrahieren.

Hierfür kommen andere Modelle zum Einsatz als die, die für die Erzeugung von Übersetzungen trainiert wurden. Die Datenmenge, die sie als Basis für ihr Training genommen haben, ist meistens sehr umfangreich – von mehreren Millionen von Parametern bis hin zu den 175 Milliarden Parametern vom GTP-3 Modell von OpenAI. Aufgrund ihrer Größe sind diese Modelle relativ gut, Zusammenhänge zu erkennen. Sie können daher Themen und Muster in Dokumenten finden und bei Bedarf auf Basis der maschinell verstandenen Informationen neue Inhalte erzeugen.

Unabhängig davon, was im Beispiel in Tabelle 02 richtig oder falsch ist, spielt die Wortwahl bei der Generierung einer Antwort eine wichtige Rolle.

Tab. 02 Quelle François Massion

Die Sätze eines Textes werden von einem KI-System als Vektor umgesetzt. Das Gleiche gilt für Fragen, die jemand stellt. Das System generiert Antworten auf Basis der berechneten Ähnlichkeit der Antwort zu der gestellten Frage. Weil Wörter mit unterschiedlicher Häufigkeit vorkommen und unterschiedliche Assoziationen haben, werden die in Tabelle 02 genannten unterschiedlichen Antworten erzeugt. Dies geschieht selbst dann, wenn diese Wörter für uns Menschen fast die gleiche Bedeutung haben.

Bei der systematischen Bearbeitung eines Sachgebiets (etwa der Bedienung einer Maschine) ist es also für Autoren sinnvoll zu testen, welche Wörter welche Informationen triggern und diese Erkenntnisse 1) in einer begriffsorientierten Terminologiedatenbank und 2) in einem Style Guide zu erfassen.

Die gleiche Wachsamkeit wie für die maschinelle Übersetzung gilt auch für die Verwendung von KI-generierten Texten. Viele generierte Texte klingen sehr gut und vernünftig. Sie können jedoch grundlegend falsche Informationen enthalten, und das ist nicht selten. KI-Systeme holen sich die Informationen nicht aus einer Wissensdatenbank, sondern generieren Sätze nach einer Wahrscheinlichkeitsrechnung, ohne sie wirklich zu verstehen. Deshalb müssen sie unbedingt von Fachleuten validiert werden.

Tab. 03 Quelle François Massion

Wohin geht die Reise?

Es ist beeindruckend und auch ein wenig beängstigend zu beobachten, wie schnell die Entwicklungen auf dem Gebiet des Verstehens natürlicher Sprache (NLU) voranschreiten. Die Größe und Leistungsfähigkeit der Modelle nehmen exponentiell zu. Das GPT-3 Modell von OpenAI wurde mit fast einer Milliarde Wörtern trainiert. Andere Sprachmodelle wie LaMDA von Google oder OPT-175B von Meta (Facebook) werden mit ähnlichen Datenmengen trainiert. Der wachsende Umfang der Trainingsdaten wird sicherlich Fortschritte beim Verstehen natürlichsprachlicher Aussagen bringen. Auch bei der maschinellen Übersetzung und der Erkennung von Fehlern in der automatischen Übersetzung werden wir bereits 2023 weitere Verbesserungen sehen.

Einige der beschriebenen Schwächen, wie das Fehlen des menschlichen logischen Denkens und des Weltwissens, werden jedoch noch lange bestehen bleiben. Auch die Methode der Bedeutungsberechnung durch Vektorvergleiche hat ihre Schwächen. Sie können ohne menschliche Unterstützung nicht behoben werden, zum Beispiel durch die Bereitstellung von maschinenlesbaren Informationen oder wissensbasierten Terminologien.

Damit eröffnen sich für Fachleute aus der Technischen Redaktion, Übersetzung oder Terminologie völlig neue Möglichkeiten und Tätigkeitsfelder. Mit Hilfe von KI können die Expertinnen und Experten Effizienzgewinne bei ihren informations- oder sprachbezogenen Aufgaben erzielen. Außerdem werden sie gebraucht, um beim Einsatz von KI bessere Ergebnisse zu erzielen.

Literatur

Porsiel, Jörg (Hrsg.) (2020): Maschinelle Übersetzung für Übersetzungsprofis: Sammelband. Berlin: BDÜ, Weiterbildungs- und Fachverlagsgesellschaft.