Neuronale Maschinelle Übersetzung (NMÜ) wird immer häufiger nachgefragt und eingesetzt. Man erwartet eine Zeitersparnis von bis zu 30 Prozent und eine Kosteneinsparung von 50 Prozent [1]. Die Annahme ist, dass ein Übersetzer mit Hilfe Maschineller Übersetzung bis zu 7.000 Wörter am Tag übersetzen kann [2]. NMÜ soll allerdings nicht den Berufsstand der Übersetzer ersetzen. Es ist eher eine logische Konsequenz aus heutiger Technik und Publikationsstrategie, nach der Content auch multilingual zur Verfügung stehen soll. Die Terminologie ist dabei die Achillesferse der Neuronalen Maschinellen Übersetzung.

Die Realität kehrt ein

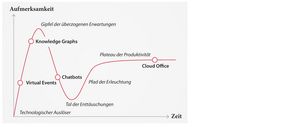

Nach Gartner durchläuft jede neue Errungenschaft verschiedene Entwicklungsstufen (Abb. 01) [3]. Ausgehend von einem technologischen Auslöser steigt der Grad der Aufmerksamkeit zunächst steil an, bis er den „Gipfel der überzogenen Erwartungen“ erreicht hat und fast ebenso schnell wieder absinkt. In der nächsten Phase erfolgt ein sehr gemäßigter Anstieg der Aufmerksamkeit, bis das Produkt das „Plateau der Produktivität“ erreicht und sich der Grad der Aufmerksamkeit auf ein reales Mittelmaß einpendelt, etwa beim Cloud Office und Plattformen wie Zoom und Microsoft Teams [3].

Abb. 01 Hype-Kurve zu "Digital Workspace"[3].

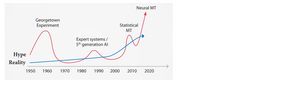

Vergleicht man diesen Verlauf mit der Entwicklung der Maschinellen Übersetzung (Abb. 02), so befinden wir uns schon im vierten Hype (rote Kurve) und sind mittlerweile bereits in der Realität angekommen (blaue Kurve) [4].

Abb. 02 Entwicklungskurve der Maschinellen Übersetzung bis zur heutigen Neuronalen Maschinellen Übersetzung [4].

Mit großem Erfolg startete bereits 1954 ein Experiment an der Georgetown-Universität. Dort wurden mit Hilfe eines IBM-Computers anhand von sechs Regeln und 250 Wörtern sechzig Sätze erfolgreich vom Russischen ins Englische übersetzt. Dies löste zunächst einen Forschungsboom aus, der abrupt gestoppt wurde. Der Tiefpunkt war 1966 erreicht, als der ALPAC Bericht zum Schluss kam, dass Maschinelle Übersetzung nicht nur deutlich langsamer, sondern auch teurer als eine Humanübersetzung sei. Von diesem Ergebnis erholte sich die Forschung nur langsam. Mit steigender Rechnerleistung und damit dem Wechsel von regelbasierten auf statistische Verfahren stieg die Qualität der Übersetzungsleistung allerdings an. Seit 2016 steht mit der Neuronalen Maschinellen Übersetzung, einer Weiterentwicklung auf Basis von Deep-Learning-Technologien, eine neuartige Übersetzungstechnologie bereit, mit der sich ein akzeptables Produktivitätslevel erreichen lässt.

Tatsächlich sind Texte, die damit übersetzt wurden, flüssiger lesbar. Im Gegensatz zu Texten, die mit regelbasierten (RBMÜ) oder statistischen (SMÜ) Verfahren übersetzt wurden und die uns viele Jahre erheitert haben. Eine Studie zeigte, dass für die Sprachrichtung Englisch zu Deutsch mit NMÜ 26 Prozent weniger Nachbearbeitung notwendig war als bei einer Übersetzung mit SMÜ [5]. Auch machte die NMÜ 19 Prozent weniger morphologische, 17 Prozent weniger lexikalische und 50 Prozent weniger Wortstellungsfehler.

Ergebnisse schwer vorhersehbar

Der Erfolg liegt im Funktionsprinzip der NMÜ: der Nachbildung eines neuronalen Netzes. Es trägt dazu bei, dass eine Übersetzung besonders flüssig zu lesen ist. Anders als beim regelbasierten Verfahren „weiß“ NMÜ nichts über Grammatik, sondern errechnet mathematisch über Vektoren die Bedeutungsähnlichkeit von Wörtern. Und anders als in der statistischen MÜ wird hier nicht mehr von Teilsätzen ausgegangen, sondern stets der ganze Satz behandelt. Dies verbessert wesentlich das flüssigere Lesen, das die Übersetzung am Ende erzielt. Das Ergebnis kann aber nicht direkt beeinflusst werden.

Zudem ist NMÜ durch das Prinzip des Deep Learning eine „Blackbox“. Die Übersetzungsergebnisse lassen sich nicht vorhersehen: Satzteile werden entweder ergänzt oder fehlen ganz. Vor allem gibt es Terminologiefehler: falsche Wörter, Wortdopplungen, Weglassungen (zum Beispiel von Verneinungen), falsch übersetzte Eigennamen und Abkürzungen [6]. Diese Terminologieprobleme sind sowohl in der regelbasierten als auch in der statistischen MÜ weniger gravierend. In beide Verfahren kann Terminologie besser eingebunden werden, allerdings mit den besagten Nachteilen, fehlender Lesbarkeit und Adäquatheit der Übersetzung. Daher benötigen alle Arten Maschineller Übersetzung, die über eine reine Inhaltserschließung hinausgehen, eine Nachbearbeitung im Post-Editing (PE).

Am Ende wird nachgearbeitet

Post-Editing unterscheidet sich von „Lektorat“, „Korrektorat“ und „Revision“, da es sich um eine Nachbearbeitung maschinell übersetzter Texte handelt. Mehr darüber steht in der DIN ISO 18587, die Vorgaben zur Qualität von Post-Editing macht.

Post-Editing kann in „Light Post-Editing“ und „Full Post-Editing“ unterteilt werden. Während im Full Post-Editing alle lexikalischen und syntaktischen Fehler, aber auch weniger offensichtliche Fehler korrigiert werden und zudem auf einen angemessenen Stil und Verständlichkeit geachtet werden muss, reicht für ein Light Post-Editing die Korrektur von lexikalischen und syntaktischen Fehlern aus. Abbildung 03 gibt dazu einen Überblick. Beide Korrekturarbeiten haben gemeinsam, dass lexikalische Fehler, sprich Terminologiefehler, immer korrigiert werden müssen [7].

Abb. 03 Aufgaben von Light Post-Editing und Full Post-Editing bei der Prüfung Maschineller Übersetzung. Quelle Samuel Läubli; nach Donald A. DePalma (2013)

Wie aber fügt sich Post-Editing (PE) in den Arbeitsprozess des Übersetzens ein? Normalerweise arbeitet heute kein Übersetzer ohne ein Translation-Memory-System (TMS). Darin wird der zu übersetzende Text vom Layout getrennt. So kann sich der Übersetzer auf die zu übersetzenden Inhalte konzentrieren und Fehler bei der Rückführung vermeiden. Zudem stehen während der Übersetzung im TMS zwei Datenbanken zur Verfügung:

a) Ein Translation Memory (TM), ein Satzdatenspeicher, in dem bereits übersetzte Segmente in Ausgangs- und Zielsprache mit weiteren Metadaten abgespeichert werden.

b) Eine Terminologiedatenbank (TDB), die den Fachwortschatz verwaltet.

Hinzu kommt die MÜ-Komponente, die auf verschiedene Weise in den Übersetzungsprozess eingebunden werden kann. Zunächst ist es nicht erheblich, um welche Art Maschineller Übersetzung es sich handelt.

In den nächsten Abschnitten werden drei verschiedene Prozesse dargestellt. Maschinelle Übersetzung, Translation Memory und Post-Editing sind dabei in unterschiedlicher Reihenfolge kombiniert. Jede hat ihre Besonderheiten.

Prozess A: Er startet mit der maschinellen Vorübersetzung – „from Scratch“. Die so erzeugten Texte werden eventuell mit PERX („Post-Editing with Regular Expressions“) automatisch nachbereitet und dem Übersetzer als MÜ-TM neben weiteren Human-TMs zur Verfügung gestellt [7, S. 302]. Eine Übersicht zeigt Abbildung 04.

Abb. 04 Zunächst startet die Übersetzung mit der Maschinellen Übersetzung. Quelle Rachel Herwartz

Gerade wenn man schon über sorgfältig aufgebaute und gepflegte Translation Memories verfügt, die bereits ein Lektorat durchlaufen haben, ist es sinnvoll, die Human-Translation-Memories höher zu priorisieren. Meistens wird für das TM aus der Maschinellen Übersetzung ein Abzug vergeben, etwa 20 Prozent. Auf diese Weise erhält der Übersetzer die guten Treffer aus dem qualitätsgesicherten TM und dann erst Vorschläge aus dem MÜ-TM.

So kann der Übersetzer vor jeder einzelnen Übersetzung mit MÜ und TM die Übersetzungsqualität prüfen und entscheiden, ob er eher der MÜ oder dem TM den Vorzug gibt. Entsprechend kann er in seinem System Abzüge eintragen. Das setzt zweierlei voraus: Der Übersetzer muss die Werkzeuge kennen. Eventuell benötigt er dafür eine Schulung. Außerdem muss sich der Übersetzungsprozess flexibel gestalten lassen.

Prozess B: Es ist ebenfalls möglich, neue Texte erst einmal anhand verfügbarer Human-TMs zu übersetzen und etwa nur die Nullprozent-Treffer maschinell übersetzen zu lassen. Der Ablauf steht in Abbildung 05.

Abb. 05 Hier beginnt die Übersetzung mit dem Translation Memory des Humanübersetzers. Quelle Rachel Herwartz

Jeder Prozess kann dabei je nach Sprachkombination, Qualität der vorhandenen Translation Memories, Qualität der eingebundenen MÜ-Systeme, Textsorte und Zielgruppe unterschiedliche Ergebnisse hervorbringen. So kann es sein, dass für Textsorte 1 in der Sprachkombination A sehr gute Human-Translation-Memories vorhanden sind und die MÜ nur eine ergänzende Rolle spielt (Prozess B). Für die Textsorte 2 in der Sprachkombination B sind die mitgelieferten TMs vom Vorgänger oder Kunden vielleicht mit Vorsicht zu behandeln. Stattdessen ist eine MÜ-Engine vorhanden, die spezifisch für den Fachbereich trainiert wurde. Sie kann aber nicht direkt angebunden werden. Hier entscheidet man sich eher für Prozess A.

Prozess C: Der dritte Prozess bindet MÜ und Translation Memories gleichwertig ein (Abb. 06). Dies setzt voraus, dass der Übersetzer in seinem Translation-Memory-System eine direkte Anbindung an ein oder mehrere MÜ-Systeme hat. Vorhandene Lizenzen und damit verbundene Kosten sind hierbei ein Faktor.

Abb. 06 Maschinelle Übersetzung und Translation Memory sind gleichwertig eingebunden. Quelle Rachel Herwartz

In diesem Prozess kann der Übersetzer während der Übersetzung von Segment zu Segment neu entscheiden, ob er dem MÜ-Treffer oder dem Treffer aus dem Human-TM den Vorzug gibt. Und nur so kann die MÜ „lernen“.

Aufgabe erfordert Konzentration

Seit der Entwicklung von NMÜ ist Post-Editing inzwischen mehr als das Verbessern des MÜ-Outputs. Eine Aufgabe, die früher keine besondere Aufmerksamkeit erforderte, da Fehler in der regelbasierten und statistischen MÜ leicht zu erkennen waren. Heute ist Post-Editing vielmehr ein sehr aufmerksames Übersetzen plus Technologie. Dies setzt einen Prozess voraus, in dem der Übersetzer alle Mittel nutzen kann, die ihm zur Verfügung gestellt werden. Dabei handelt es sich um bereits gespeicherte und idealerweise qualitätsgesicherte Segmente im Translation Memory, die direkte Anbindung an das MÜ-System sowie die Termerkennung aus einer Terminologiedatenbank. Außerdem sollte er die Möglichkeit bekommen, über Qualitätssicherungstools verschiedene Prüfroutinen im Anschluss an die Übersetzung durchzuführen, wie zum Beispiel nicht übersetzte Segmente oder fehlende Tags.

Um das Terminologieproblem zu lösen, das in der Neuronalen Maschinellen Übersetzung gehäuft auftritt, ist die Anbindung an eine Terminologiedatenbank Pflicht. Während Translation Memories auch veraltete bzw. verbotene Benennungen enthalten können und MÜ-Systeme Terminologie in der Zielsprache falsch, inkonsistent, wörtlich oder auch gar nicht übernehmen, wird in der Terminologiedatenbank die Verwaltung und Entscheidung über die Terminologie eines Unternehmens oder einer Behörde dokumentiert.

NMÜ liegt daneben

In Abbildung 07 sieht man, was den Wert der Terminologiedatenbank ausmacht und wie konzentriert der Übersetzer bei der Nachbearbeitung des NMÜ-Outputs sein muss. Das Beispiel stammt aus einem Übersetzungsprojekt, das sich zunächst aus Treffern eines Human-TM bedient und dann Segmente ohne Treffer mit Hilfe von NMÜ übersetzt. Im Editor, unterer Bereich, werden auf der linken Seite die Segmente in der Ausgangssprache und auf der rechten Seite die Segmente in der Zielsprache angezeigt. Links oben werden Treffer aus einem dazugeschalteten Translation Memory für diesen Satz angezeigt. Da es noch keinen Treffer gegeben hat, ist das Feld leer.

Abb. 07 Screenshot aus einem Schulungsvideo über ein Übersetzungsprojekt; durchgeführt in Trados Studio mit SDL Machine Translation Cloud Provider als NMÜ. Quelle RWS; Ziad Chama

Im zweiten Segment, im Editor links unten, sieht man die Tücken flüssig lesbarer NMÜ-Ergebnisse: „und machen Sie den Prüfer zu einem detaillierteren Blick auf das überprüfte Dokument“. Hier hakt es doch gewaltig in der Übersetzung von „and make the reviewer take a more detailed look at“. Der Post-Editor bzw. Übersetzer in der Funktion eines Post-Editors muss sehr konzentriert arbeiten, gleichzeitig schnell entscheiden, was zu ändern ist. Dazu benötigt er die bestmögliche Unterstützung – für die Satzfragmente und für die Terminologie.

In Abbildung 07 rechts oben wird die Termerkennung einer hinterlegten Termbank angezeigt. Im zweiten Segment des Editors im linken unteren Teil werden jetzt im Ausgangssegment die Treffer aus der Termbank jeweils mit roten Überstreichungen gekennzeichnet. So kann der Übersetzer erkennen, dass die Übersetzung von „Review phase“ mit „Überprüfungsphase“ eine mögliche Übersetzung darstellt. Für das Wort „reviewer“ wäre aber laut Termbank nur die Benennungen „Korrekturleser“ oder „Lektor“ erlaubt, nicht aber „Prüfer“. Das ist die Benennung, die aus der Neuronalen Maschinellen Übersetzung stammt.

Daher muss die Termbank präskriptiv vorgeben, welches der Synonyme verwendet werden soll. Häufig ist es ein Versäumnis bei der Einarbeitung, der Schulung oder der Kommunikation zwischen Projektmanagement und Übersetzer, wenn weitere Datenkategorien wie „erlaubt“ und „verboten“ in der Termbank vorhanden sind, diese jedoch nicht angezeigt werden.

Angepasst sieht das Beispiel von Trados Studio mit gleichzeitiger Anzeige von Treffern aus Human-TM und NMT sowie weiteren Attributen in der Termbank wie folgt aus: in der linken oberen TM-Anzeige werden zwei Treffer angezeigt, einer aus dem Translation Memory, hier aus MateCat, einem anderen TMS, und ein zweiter aus der NMÜ (Abb. 08). In der Ansicht oben rechts aus der Terminologiedatenbank werden auch die Attribute zur Verwendung dargestellt. So hat der Übersetzer alle Informationen für das Post-Editing.

Abb. 08 Gleiches Beispiel wie Abb. 07 diesmal übersetzt mit SDL Language Cloud und TM aus MateCat. Quelle Rachel Herwartz

Allerdings benötigt das gründliche Lesen und Vergleichen aller Vorschläge oftmals zusätzliche Zeit. Eine schnelle Entscheidung, ob ein MÜ-Segment im Sinne eines Light Post-Editing oder Full Post-Editing übernommen werden kann, wird erschwert. Jedoch gibt gerade diese Arbeitsweise Übersetzern und Post-Editoren ihre Eigenständigkeit zurück. Sie entscheiden selbst, welcher Treffer – MÜ-Output oder Fuzzy Match – am wenigsten nacheditiert werden muss [8].

Terminologie einbinden

Bei den meisten MÜ-Systemen kann man mittlerweile in der Phase der Maschinellen Übersetzung die Terminologiefindung in der Zielsprache durch hinzuzufügende Glossare (Glossary) oder Wörterbücher (Dictionaries) beeinflussen. Hier zeigt sich aber an der Bezeichnung „Glossary“, dass keine begriffsorientierte und benennungsautonome, präskriptive Termdatenbank gemeint ist, die mit Synonymen, Homonymen, Abkürzungen und Eigennamen umgehen kann. Erwartet werden in der Regel nicht mehr als bilinguale Termlisten mit erlaubten Benennungen in Ausgangs- und Zielsprache, die daher bevorzugt als CSV oder TMX geliefert werden. Mit komplexen TBX-Strukturen bzw. Dialekten wissen die MÜ-Systeme bislang wenig anzufangen.

Daher kommt diese zusätzliche Terminologiekomponente häufig nicht über ein nachträgliches „Suchen und Ersetzen“ in der Zielsprache hinaus (Inf. 01). Das zerstört die flektierten Formen des ursprünglich grammatikalisch korrekten Zieltextes. Die Anwendung DeepL macht durch eine blaue Schriftfarbe deutlich, wo im Text Terminologie aus dem Glossar übernommen wurde. So kann man gezielter auf die Stellen schauen und falls nötig nachbessern (Abb. 09). Im Beispiel in Abbildung 09 haben „Prüfer“ (ohne Glossary) und „Lektor“ (mit Glossary) zum Glück das gleiche Genus.

Abb. 09 Beispiel aus Abbildung 07, übersetzt mit DeepL mit Glossary-Funktion. Quelle Rachel Herwartz

Damit ein Glossar funktioniert, ist ein fach- und zielgruppenspezifischer Export aus einer Terminologiedatenbank mit eindeutigen Entsprechungen in Ausgangs- und Zielsprache notwendig. Das heißt, dass jede Benennung in der Ausgangssprache nur genau eine Benennung in der Zielsprache haben darf, damit das MÜ-System sie versteht [9].

Aus diesem Grund darf der Ausgangstext auch keine Homonyme enthalten, was das Pre-Editing sicherstellen muss. Eine Lösung ist, das MÜ-System direkt mit einem Terminologieprüfprogramm zu verknüpfen, das Ausgangs- und Zielsprache analysiert. Das Prüfprogramm verwendet wie ein TMS eine Termdatenbank und kann alle weiteren relevanten Attribute der Termbank in der Prüfung anzeigen.

| Stand der Entwicklung |

Versuche, die Terminologie zum Beispiel über eine stärkere Gewichtung im Training, Term-Injection oder Ontologien anzureichern, sind allerdings noch im Forschungsstadium; oder das Ergebnis sind Terminologievorschläge, die dazu führen, diese Komponente schnellstmöglich wieder abzuschalten. Inf. 01 Quelle Rachel Herwartz |

In der richtigen Reihenfolge

Wird bei der Maschinellen Übersetzung nicht nur die Terminologie im Zieltext, sondern im Sinne eines Pre-Editing die Terminologie des Ausgangstextes als Erstes geprüft, so sieht man direkt die Auswirkungen auf die Zielsprache. Gleichzeitig stellt man sicher, dass die Ausgangssprache für das NMÜ verständlich ist und keine Homonyme enthält.

Ein Beispiel ist ein RKI-Text zu Covid-19. Der Text soll mit einer speziell für dieses Fachgebiet trainierten Engine vom Deutschen ins Englische übersetzt werden. Wenn durch die Terminologieprüfung im Ausgangstext angezeigt wird, dass COVID-19 und SARS-CoV2 die vom RKI bevorzugten Schreibweisen sind, ändert sich nach Korrektur auch direkt die Übersetzung bzw. Schreibweise in der Zielsprache (Abb. 10) – ein Pre-Editing mit direktem Erfolgsergebnis. Nachdem der deutsche Ausgangstext korrigiert wurde, ist die Fehleranzahl im englischen Zieltext gesunken (Abb. 11).

Abb. 10 Pre-Editing und Terminologieprüfung mit termXact Online im MÜ-System Systran; basierend auf der Termbank „Pandemology“ [10]. Quelle Rachel Herwartz

Abb. 11 Post-Editing in der Zielsprache. Quelle Rachel Herwartz

Voraussetzung für den sinnvollen Einsatz der Neuronalen Maschinellen Übersetzung ist somit vor allem ein kontrolliertes Vokabular. Damit gemeint ist präskriptive Terminologiearbeit: abgestimmte Terminologie mit plausiblen und nachvollziehbaren Entscheidungen in begriffsorientierten und benennungsautonomen Terminologiedatenbanken mit zielgruppenspezifischen Exporten für die MÜ-Engines. Wichtig ist ebenfalls ein gutes Zusammenspiel aller Komponenten, die die Nachbearbeitung einer Maschinellen Übersetzung durch den Menschen erleichtern – im Pre-Editing, im Post-Editing und in der Qualitätssicherung. Durch den Einsatz von NMÜ ist Post-Editing mehr als das Bereinigen von Fehlern. Post-Editing wandelt sich vielmehr zur „Augmented Translation“.

Links und Literatur zum beitrag

[1] Beßler, Patrick/Burchardt, Aljoscha (2020): Gute Qualität zum kleinen Preis? Wandel von Erwartungen und Prozessen im Kontext von Maschineller Übersetzung. In: Porsiel, Jörg (2020): Maschinelle Übersetzung für Übersetzungsprofis, S. 22. Sammelband.

[2] Massion, François (2020): NMT im Einsatz bei einem Dienstleister: von der Systemauswahl bis zum fertigen MÜ-Workflow. In: Porsiel, Jörg (Hrsg.): S. 272.

[3] Kombinierte Grafik: http://en.wikipedia.org/wiki/File:Gartner_Hype_Cycle.svg und https://cogneon.de/2020/08/27/die-6-trends-2020-fuer-den-digitalen-arbeitsplatz-aus-dem-gartner-hype-cycle-for-the- digital-workplace/

[4] Köhn, Philipp (2020): Neural Machine Translation.

[5] Bentivogli, Luisa et al. (2016): Neural versus Phrase-Based Machine Translation Quality: A Case Study. In: Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing.

[6] Winter, Tom/Zielinski, Daniel (2020): Terminologie in der neuronalen maschinellen Übersetzung. In: Porsiel, Jörg (2020): Maschinelle Übersetzung für Übersetzungsprofis, S. 216ff. Sammelband.

[7] Wallberg, Ilona (2020): DIN ISO 18587 in der Praxis. In: Porsiel, Jörg (Hrsg.).

[8] Grizzo, Sara (2020): Hat Post-Editing ausgedient? In: Porsiel, Jörg (Hrsg.): S. 360.

[9] Läubli, Samuel (2021): Maskierung und Provokation. Wie sich die Qualität der Terminologie in der NMÜ verbessern lässt. In: eDITion, 1/202, S. 40.

[10] Herwartz, Rachel (2021): Terminologie geht neue Wege. In: technische kommunikation. H. 2, S. 32–37.

Literatur zum Weiterlesen

Eisold, Christian (2017): Zur Rolle der Terminologie in der maschinellen Übersetzung. In: Porsiel, Jörg (Hrsg.): Maschinelle Übersetzung. Grundlagen für den professionellen Einsatz.

Porsiel, Jörg (Hrsg., 2020): Maschinelle Übersetzung für Übersetzungsprofis. Sammelband.

eDITion 1/2021: Neuronale Maschinelle Übersetzung